Cin : De même, et de mon avis personnel, la relation complexe et parfois contradictoire entre l’IA et la durabilité nécessite également une réflexion attentive. Même si je dois admettre que, dans son intervention, Jenny Ambukiyenyi Onya a développé un point de vue très positif sur les données et l’économie durable, en parlant de Halisi Livestock. Cette solution utilise des fonctions avancées de l’IA et de la biométrie pour aider les agriculteurs et les institutions financières à améliorer l’accès au capital pour les populations défavorisées. Elle transforme ainsi le paysage de l’agro-fintech en Afrique.

La science des données est omniprésente dans l’actualité de nos jours, en particulier avec l’essor de l’IA. S’agit-il d’un thème purement technique ou cela va-t-il au-delà ?

Cin : La technologie et l’IA en particulier améliorent sans aucun doute la productivité et l’efficacité, en particulier pour les tâches répétitives, dangereuses ou ingrates. Cependant, l’accent devrait être mis sur l’utilisation de l’IA pour augmenter les capacités humaines, et non pour les remplacer. Imaginez que nous devenions des « surhumains », avec une technologie qui améliore notre façon de penser et d’agir. Pensez aux implants alimentés par l’IA qui peuvent permettre aux gens d’entendre à nouveau ou de marcher après une paralysie. À cet égard, j’aimerais partager une de mes recommandations personnelles préférées : « Le dilemme numérique. » Cette série documentaire flamande diffusée sur VRT MAX par le journaliste Tim Verheyden explore l’impact de l’innovation technologique sur les personnes et la société.

Quelle est la valeur ajoutée des femmes dans la science des données ?

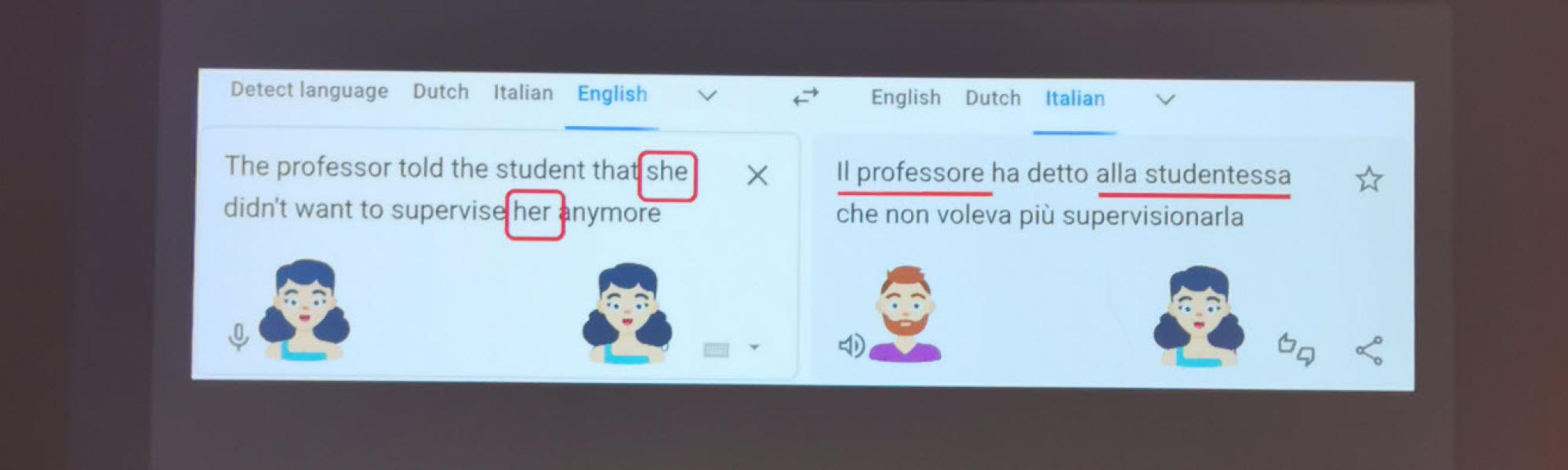

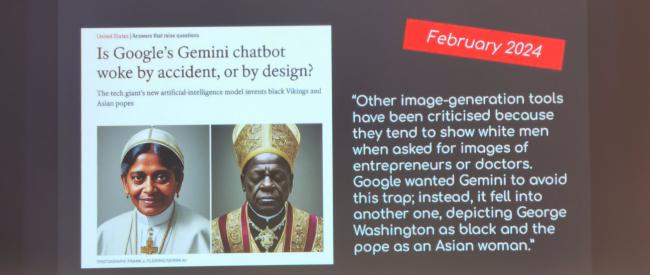

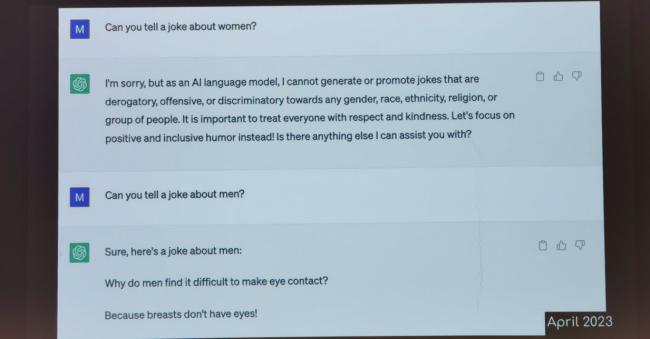

Cin : Notre cerveau fonctionne différemment, et la diversité de pensée est cruciale dans la science des données et ses implications commerciales. Des personnes d’origines différentes apportent des perspectives uniques qui peuvent mener à des solutions innovantes. Chez KBC, un grand nombre de scientifiques des données sont des femmes. Ce succès est dû à une combinaison de facteurs : initiatives d’apprentissage STEM, solides compétences mathématiques intrinsèques ou encore bons résultats académiques chez beaucoup de femmes, ainsi qu’à leur capacité à fournir d’autres approches.

Rossana : Un groupe plus diversifié fournira toujours des solutions plus diverses. Nous nous concentrons aujourd’hui sur les femmes, mais cela s’applique également à d’autres minorités telles que des personnes d’autres nationalités, classes d’âge ou en situation de handicap. Pour moi, c’est une situation classique de l’œuf et de la poule, ou du serpent qui se mord la queue si vous voulez. Nous avons besoin de plus de femmes ayant des origines et des mentalités différentes dans la science des données pour réduire les biais, mais le manque de diversité pourrait décourager certaines femmes de se lancer dans l'aventure. Des conférences comme celle de Gand peuvent jouer un rôle crucial dans la sensibilisation et la destruction de ces obstacles.

Avez-vous d’autres choses à partager avec nous ?

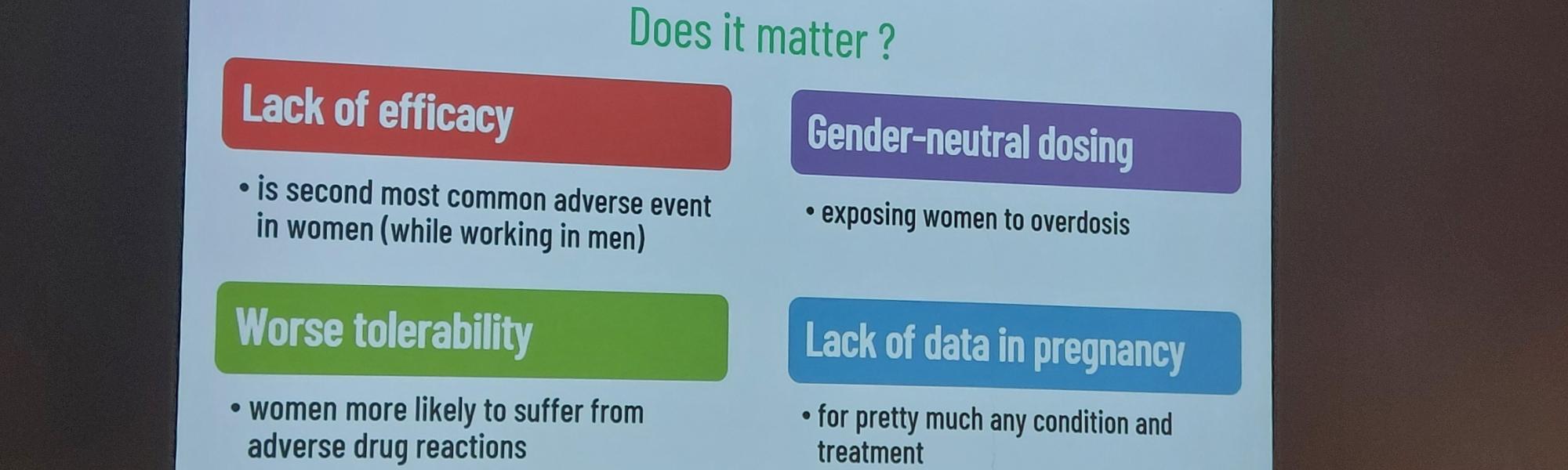

Cin : Ce qui m’a frappé, c’est la session sur l’invisibilité des données sur les femmes dans la recherche scientifique. Elle a mis en évidence un problème critique en montrant ce que peut provoquer le manque de données féminines dans la recherche scientifique : médicaments inefficaces ou encore réactions indésirables aux médicaments qui peuvent exposer les femmes à un surdosage. Même l’absence de données pendant la grossesse, souvent motivée par la volonté d’éviter les risques, limite les options des femmes pour gérer divers problèmes de santé pendant leur grossesse. Alors, comblons l’écart.